- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Naposledy zmenené 2025-01-22 17:39.

1) Problém s malým súborom v HDFS : Ukladanie veľkého množstva malé súbory ktoré sú mimoriadne menšie veľkosť bloku nie je možné efektívne zvládnuť HDFS . Prečítanie malé súbory zahŕňajú veľa vyhľadávaní a veľa preskakovania medzi dátovým uzlom a dátovým uzlom, čo je zase neefektívne spracovanie dát.

Okrem toho, ktoré súbory riešia problémy s malými súbormi v Hadoop?

1) HAR ( Hadoop archív) Súbory bol predstavený riešiť problém s malým súborom . HAR zaviedol vrstvu na vrchu HDFS , ktoré poskytujú rozhranie pre súbor pristupovanie. Použitím Hadoop archívny príkaz, HAR súbory sú vytvorené, ktoré beží a MapReduce prácu zbaliť súbory archivuje sa do menšie počet HDFS súbory.

Okrem toho, môžem mať viacero súborov v HDFS, ktoré používajú rôzne veľkosti blokov? Predvolené veľkosť z blokovať je 64 MB. vy môcť zmeniť v závislosti od vašej požiadavky. K tvojej otázke áno môže vytvoriť viacero súborov variovaním veľkosti blokov ale v reálnom čase toto bude nezvýhodňujú výrobu.

Navyše, prečo HDFS nespracúva malé súbory optimálne?

Problémy s malé súbory a HDFS Každý súbor , adresár a blokovanie HDFS je reprezentovaný ako objekt v pamäti menného uzla, z ktorých každý zaberá 150 bajtov, ako orientačné pravidlo. ďalej HDFS nie je zamerané na efektívny prístup malé súbory : to je primárne určený pre streamingový prístup veľkých súbory.

Prečo je Hadoop pomalý?

Pomaly Rýchlosť spracovania Toto vyhľadávanie disku si vyžaduje čas, čím je celý proces veľmi náročný pomaly . Ak Hadoop spracováva údaje v malom objeme, je to veľmi pomaly porovnateľne. Je ideálny pre veľké súbory údajov. Ako Hadoop má jadro dávkového spracovania, jeho rýchlosť spracovania v reálnom čase je nižšia.

Odporúča:

Aký je problém v TFS?

Problém je vlastnosť pracovnej položky, ktorá vám umožňuje zoskupiť ju s inými pracovnými položkami, ktoré môžu byť problematické. Ak chcete niečo označiť ako problém, musíte to urobiť manuálne pri vytváraní pracovnej položky

Aký je rozdiel medzi programovými súbormi a programovými súbormi 86x?

Bežný priečinok Program Files obsahuje 64-bitové aplikácie, zatiaľ čo „Program Files (x86)“sa používa pre 32-bitové aplikácie. Inštalácia 32-bitovej aplikácie do počítača so 64-bitovým systémom Windows sa automaticky presmeruje na Program Files (x86). Pozrite si Program Files andx86

Aký je rozdiel medzi súbormi PowerPoint PPT PPTX a PPS Ppsx?

Rozdiel spočíva v tom, ako s nimi PowerPoint zaobchádza: V predvolenom nastavení sa súbory PPT a PPTX otvárajú v režime úprav v programe PowerPoint, čo vám umožňuje používať všetky ponuky a príkazy. V predvolenom nastavení sa súbory PPS a PPSX otvárajú v režime prezentácie (prehrávanie-prezentácia) a nevidíte žiadne rozhranie programu PowerPoint

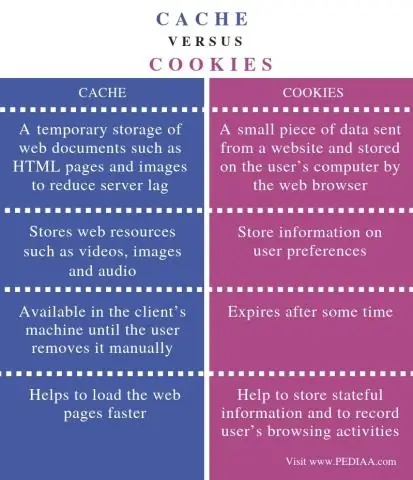

Aký je rozdiel medzi vymazaním vyrovnávacej pamäte a súbormi cookie?

Hlavným rozdielom medzi vyrovnávacou pamäťou a súborom cookie je, že vyrovnávacia pamäť sa používa na ukladanie zdrojov online stránok počas prehliadača na dlhodobé účely alebo na skrátenie času načítania. Na druhej strane sa súbory cookie používajú na ukladanie používateľských volieb, ako je napríklad relácia prehliadania, na sledovanie používateľských preferencií

Ako narábate so súbormi zip?

Komprimujte a rozbaľte súbory Nájdite súbor alebo priečinok, ktorý chcete zazipovať. Stlačte a podržte (alebo kliknite pravým tlačidlom myši) na súbor alebo priečinok, vyberte (alebo ukážte na) Odoslať do a potom vyberte Komprimovaný (zazipovaný) priečinok. Na rovnakom mieste sa vytvorí nový zazipovaný priečinok s rovnakým názvom