- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:52.

- Naposledy zmenené 2025-01-22 17:39.

Zatiaľ čo Spark podporuje načítanie súbory z miestne súborový systém, vyžaduje, aby súbory sú dostupné na rovnakej ceste na všetkých uzloch vo vašom klastri. Niektoré sieťové súborové systémy, ako napríklad NFS, AFS a vrstva NFS MapR, sú používateľovi vystavené ako bežný súborový systém.

Následne sa možno spýtať, ako spustím iskru v lokálnom režime?

In lokálny režim , iskra pracovných miest behať na jednom počítači a sú vykonávané paralelne pomocou multi-threadingu: toto obmedzuje paralelizmus (najviac) na počet jadier vo vašom počítači. Komu behať pracovné miesta v lokálny režim , musíte si najprv rezervovať stroj cez SLURM v interaktívnom režim a prihláste sa do nej.

Okrem vyššie uvedeného, čo je SC textFile? textový súbor je metóda org. apache. SparkContext trieda, ktorá znie a textový súbor z HDFS, lokálneho súborového systému (dostupného na všetkých uzloch) alebo z ľubovoľného URI súborového systému podporovaného Hadoopom a vrátiť ho ako RDD reťazcov.

Čo je v tomto ohľade iskrový súbor?

The Spark File je dokument, kde si uchováte všetku svoju tvorivú dobrotu. Definoval ju autor Stephen Johnson. Takže namiesto toho, aby ste si uprostred noci škrabali poznámky na Post-it® alebo venovali nápadom rôzne časopisy, dáte všetky svoje koncepty do jedného súbor.

Čo je paralelná zberná iskra?

Operácie s distribuovanými súbormi údajov popíšeme neskôr. Paralelizované zbierky sú vytvorené volaním JavaSparkContext 's paralelizovať metóda na existujúcom Zbierka vo vašom programe ovládača. Prvky z zber sú skopírované, aby vytvorili distribuovaný súbor údajov, ktorý možno prevádzkovať paralelne.

Odporúča:

Dokáže Python čítať súbory ZIP?

Na prácu so súbormi zip pomocou pythonu použijeme vstavaný modul pythonu s názvom zipfile. print ('Hotovo!' ZipFile je trieda modulu zipfile na čítanie a zapisovanie súborov zip. Tu importujeme iba triedu ZipFile z modulu zipfile

Dokáže finále čítať súbory PDF?

Pro-tip: Súbor môžete otvoriť aj vo Finale výberom súboru vo svojom vyhľadávači a kliknutím pravým tlačidlom myši. Potom vyberte „Otvoriť pomocou…“a na paneli programov vyberte Finale. Gratulujem! Úspešne ste importovali súbor PDF do Finale pomocou ScanScore

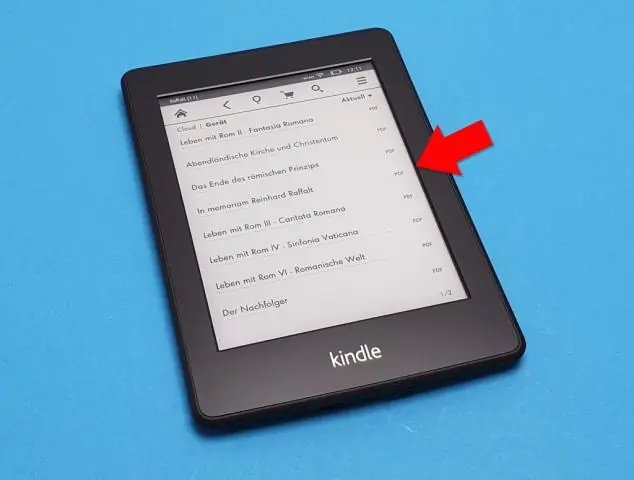

Dokáže nook čítať súbory PDF?

Dokumenty, ktoré môžete pridať do Nookinclude PDF, čo môžu byť knihy alebo iné kratšie dokumenty. Súbory PDF v Nook možno čítať rovnako ako akúkoľvek inú zakúpenú knihu a zariadenie môžete synchronizovať kopírovaním dokumentov z počítača do Nook. Dvakrát kliknite na priečinok „Knihy“alebo „Dokumenty“na disku Nook

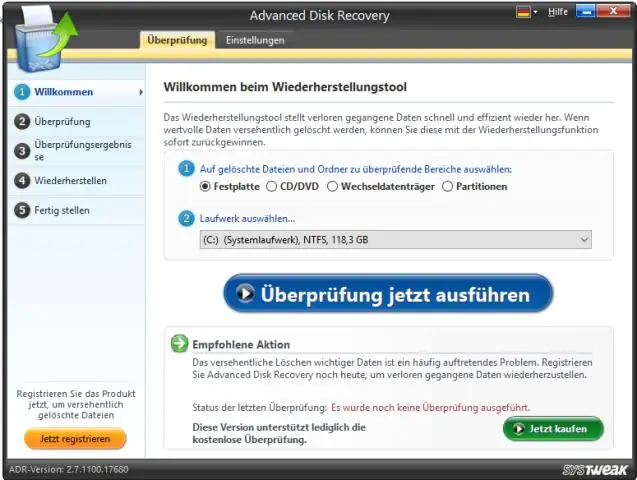

Dokáže Windows 10 čítať nespracované súbory?

Windows 10 sa nedodáva s natívnou podporou pre prezeranie neupravených obrázkových súborov, čo znamená, že používatelia nemôžu zobraziť miniatúry ani metadáta v aplikácii Fotky alebo Prieskumník súborov Windows. Spoločnosť Microsoft má riešenie pre fotografov, ktorí túto schopnosť potrebujú, a nazýva sa rozšírenie Raw Image Extension

Dokáže Python čítať súbory MAT?

Počnúc vydaním 7.3 Matlabu sa súbory mat v skutočnosti štandardne ukladajú pomocou formátu HDF5 (okrem prípadu, keď pri ukladaní použijete príznak -vX, pozri v Matlabe). Tieto súbory je možné čítať v Pythone napríklad pomocou balíka PyTables alebo h5py